Veeam BR简述

Veeam Backup & Replication (简称 Veeam BR)是一款数据保护软件,为 VMware 和 Hyper-V VM、物理与云环境提供了备份、复制与恢复功能。

Replication作业优化

环境:vCenter上添加了 vSAN 群集及 1 台 Veeam ESXi 服务器,后端连接了10Gb 网络(192.168.10.0/24);但是 vCenter 未连接到 10Gb 网络。

| 服务器 | IP 地址 | 说明 |

|---|---|---|

| Veeam ESXi |

MGT:2.2.2.50/24 vSAN:192.168.10.50/24 |

ESXi 主机,加入 vCenter6 管理。 Veeam BR虚拟机的宿主。 |

| Veeam BR |

MGT:2.2.2.100/24 vSAN:192.168.10.100/24 |

Veeam BR 备份服务器,Host 解析到192.168.10.0/24。 存储器名称:Backup |

| vCenter6 | MGT:2.2.2.10/24 | 1G 管理网络单网卡,Host 解析到 2.2.2.0/24。 |

| esxi-6a |

MGT:2.2.2.11/24 vSAN:192.168.10.11/24 |

vSAN 群集 ESXi 主机,加入 vCenter6 管理。 |

| esxi-6b |

MGT:2.2.2.12/24 vSAN:192.168.10.12/24 |

vSAN 群集 ESXi 主机,加入 vCenter6 管理。 |

| esxi-6c |

MGT:2.2.2.13/24 vSAN:192.168.10.13/24 |

vSAN 群集 ESXi 主机,加入 vCenter6 管理。 |

| RHEL6 | N/A |

运行在 vSAN 群集,被 vCenter6 管理。 存储器名称:vsanDatastore |

需求:将 vSAN 上的虚拟机同步到 Veeam ESXi 服务器,通过 10Gb 网络来传输同步数据

- 问题:配置 Replication 作业后,同步速率 200Mb 浮动;Backup 作业速率达 1.5Gb。

- 排障:

- 分析源及目标 ESXi 主机网络连接:

esxcli network ip connection list | grep -i '192.168.10' - 分析 Veeam 备份服务器网络连接:

netstat -ano | find /i "192.168.10"

- 分析源及目标 ESXi 主机网络连接:

- 参考:

Replication 架构参考

Backup 架构参考

备份 VSAN 上的虚拟机 - 优化:

应用场景 分析与建议 场景 I/O 读写 - 更改 Backup Proxy 策略,将 Automatic selection 更改为 Network(强制使用 nbd 方式同步,Automatic 会尝试 hotadd 再尝试 nbd);

- 在不同的虚拟化环境、资源策略及硬件性能不均衡的情况下,可以尝试不同的优化方案;直接 I/O 写入磁盘或网络转存到内存再写入磁盘。

备份通道的区别 - hotadd 是将虚拟磁盘挂载到 Backup Proxy 服务器进行本地读写、需要访问虚拟机所在的存储器;

- nbd 是 Backup Proxy 做数据中转、负责接收和传送备份数据,直接与 ESXi 主机进行通信。

随机读写性能低 - 同步数据块不连续而需要从 Source 端读取并写入到 Target 端,数据进行了去重和压缩处理、导致同步速率下降(随机数据块读写性能低);

- 此场景建议 Veeam Backup Server 服务器的 CPU 和内存配置调高些,如:8 核 CPU、16GB 内存;

- 可以尝试通过 SSD 做数据缓存来提高随机读写性能或者将数据分布存储。

升级底层 RAID 卡 使用大缓存(如4G缓存)的 RAID 卡;提升存储端的 I/O 读写。 并发 I/O 大性能低 - 针对多个 Replication Job 同时执行的情况,需要针对 Source 和 Target 端 ESXi 主机的存储器进行 I/O 性能监测;

- 发现 Target 端在进行首次全量复制时速率正常且只有写 I/O、而增量复制时速率大大下降且有读和写 I/O;

- 建议将 I/O 分散到不同的 Target 端存储器或更改为 Backup 方式来备份。

10Gb网络 MTU - ESXi 虚拟化系统默认网卡 MTU 值为 1500,建议对 10Gb 网卡上的 vSwitch 及 VM kernel 设置 MTU 值为 9000;

- 前提条件是硬件网络交换机已经配置了 MTU 值为9000。

针对 Replication 架构 - 当 Source 和 Target 端在不同存储器时,建议Source 和 Target 端分别部署 Backup Proxy 来直接挂载 VMDK,Backup Proxy 之间通过 10Gb 网络来交换差分(增/删/改)数据,Target 端会做快照整合;

- Source Backup Proxy 和 Target Backup Proxy 在 Target 端主机上时读写 I/O 请求过高,原厂工程师回复读 I/O 由于 Source Backup Proxy 缓存数据和数据压缩去重导致?

针对 Windows 虚拟机 检查磁盘碎片整理周期;系统默认为每周执行,该动作会移动数据块造成 CBT 增量数据;建议每周或每月执行。 针对增量数据过大的应用 - 可以从系统架构层面将数据就系统应用分离、存放在不同的虚拟磁盘上;

- 虚拟机备份时只需要备份系统及应用程序所在虚拟磁盘,应用数据可以通过相应的备份软件来进行备份、如果要求备份较大数据量且 RTO 时间小于 4 小时,应该选择支持挂载备份数据及保存修改数据到备份文件的备份软件。

需求:保持虚拟机同步后 MAC 地址一致

- 优化:vCenter 集中管理的情况下,自动模式 MAC 地址会被调整、必须设置为手动 MAC;通常情况下多台虚拟机 MAC 地址相同时会出现错误报警,可以在 vCenter 警报中关闭“虚拟机 MAC 冲突”。

需求:解决系统日志“Ntfs Event ID 140”警告

- 优化:以管理员身份运行CMD程序,执行命令

mountvol /n

Job 关键参数用途

| 配置参数 | 配置方法 | 应用场景 |

|---|---|---|

| Changed block tracking 简称:CBT |

Job Setting ↓ Advanced ↓ vSphere ↓ Changed block tracking |

|

| Compression level | Job Setting ↓ Advanced ↓ Traffic ↓ Compression level |

|

| Storage optimization | Job Setting ↓ Advanced ↓ Traffic ↓ Storage optimization |

|

| Application-aware | Guest Processing ↓ Enable application-aware processing |

|

Job 异常分析处理

- 复制作业:增量作业在没有vCenter全局管理员权限的情况下,会有 “Failed to set storage profile Default to disk” 警告,由于该vCenter认证帐号没有存储策略读取权限;添加 “配置文件驱动的存储视图” 权限后解决。

- Veeam控制台:登陆时提示 “Access to registry key 'HKEY_LOCAL_MACHINE\SOFTWARE\Veeam\Veeam Backup and Replication' is denied.”,由于 Windows Users 组用户对该注册表项及子键没有读取权限;为用户添加该注册表项及子键读取权限即可。

- 复制作业:源虚拟机 A1 与目标虚拟机 A2 在同一存储器上、复制作业用于复制 Veeam Server 服务器;执行复制作业时、某些时候虚拟机 A2 挂载了虚拟机 A1 的磁盘,导致 Veeam Server 服务器无法检测到虚拟磁盘被挂载,读取数据失败。正常情况下是虚拟机 A1 挂载虚拟机 A2 的磁盘来进行复制(nbd --> hotadd)。在 vsan存储器环境下可能导致虚拟机因 “保存快照出错: msg.snapshot.error-CHECKPOINT”,导致无法开机并提示 “找不到 xxx.vmdk” 文件;VMware 回复无法修复 vmdk 元数据(原厂工程师回复由于对象没有 owner 的情况下 vsan 管理进程认为是无效数据便删除相关对象),建议不要以虚拟机备份方式备份 Backup Server 及 Backup Proxy。

备份与复制对比

| Job Type | Replication | Backup |

|---|---|---|

| 故障恢复 |

|

|

| 增量备份 I/O(供参考) |

|

|

| 增量备份数据 |

|

|

| 全量备份数据 |

|

|

备份作业保留一份全备的做法

前提条件:需要预留存储器可用空间约 1 次备加上 1 次增量备份的空间,用于全量备份数据整合;建议预留额外 10% 可用空间。推荐使用 9.5 u4 以上版本。

操作步骤:

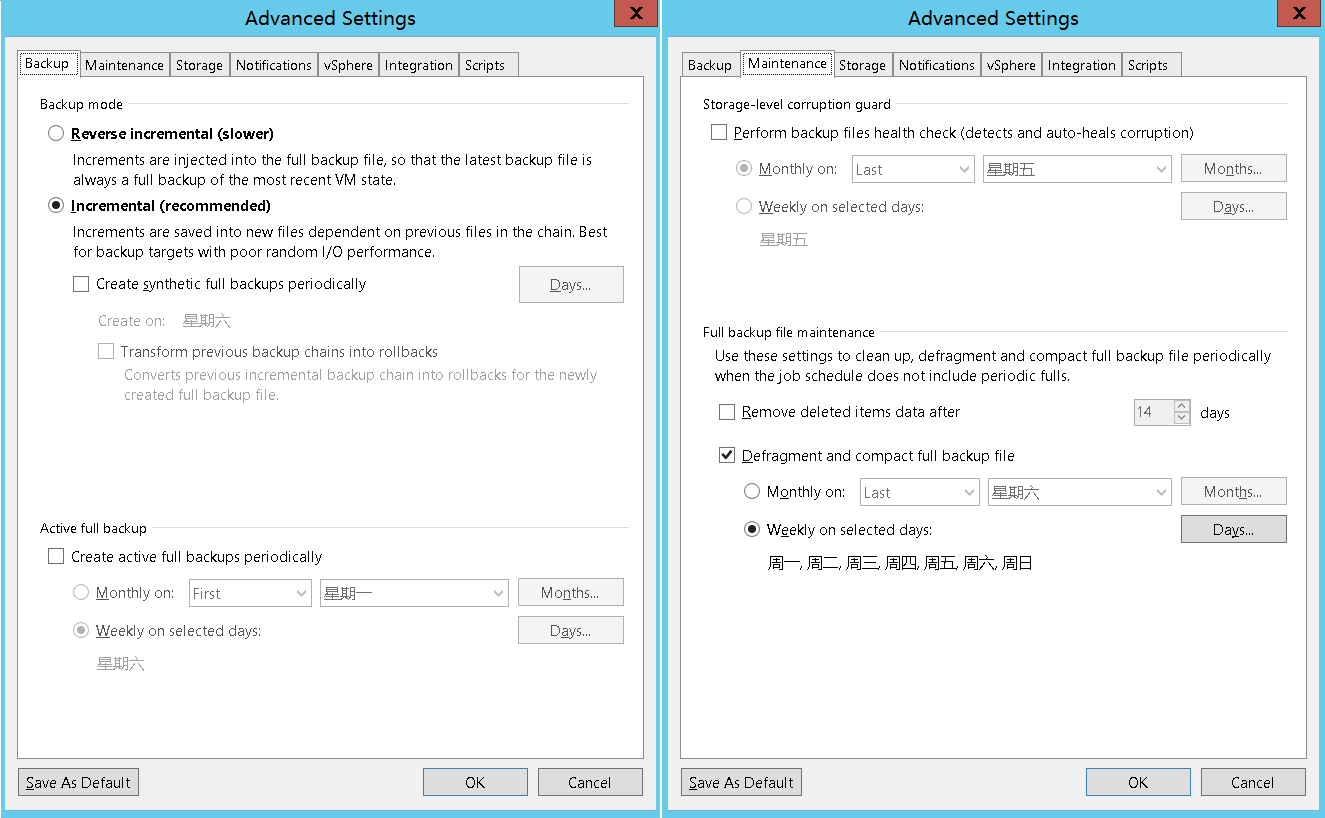

- 编辑作业 → Advanced Settings → Backup 菜单下,勾选“Incremental (recommended)”选项;

- Advanced Settings → Maintenance 菜单下,勾选“Defragment and compact full backup file”选项,勾选“Weekly on selected days”选项并将日期指定为周一至周日,也就是每次增量备份后都整合为新的全备;

- 注意:在 Advanced Settings → Backup 菜单下,不要勾选其他选项;除非已经执行了全备任务、则必须勾选“Create synthetic full backups periodically”选项(同样将日期指定为周一至周日) 和 “Transform previous backup chains into rollbacks”选项;此操作需要将全量备份数据(F-OLD)与增量备份数据(I-OLD)整合成为一个新的全量备份数据(F-NEW)并产生额外的缓存文件。整合过程中会额外占用一个全量备份数据(F-NEW)的空间,整合完成合会自动删除旧的全量备份数据(F-OLD)和旧的增量备份数据(I-OLD)。

- 在不配置“Defragment and compact full backup file”的情况下,Veeam 仍然会依照保留策略中的设定执行合成全备;该配置用于解决全备数据碎片化问题(参考:Compact of Full Backup File)。

文章出自: 本站技术文章均为原创,版权归 "Desen往事 - 个人博客" 所有;部分图片来源于 Yandex ,转载本站文章请注明来源。